Hinweis: Alles ändert sich in diesem Bereich so schnell, dass das eine oder andere Detail abweichen kann. Gerade die Tools entwickeln sich mit einer hohen Geschwindigkeit weiter.

Bis jetzt bin ich auf KI eingegangen, die bei den grossen BigTech Firmen entwickelt und betrieben wird. Wenn Sie sich diese Firmen anschauen, dann sind es die grossen Datensammler: Microsoft, Amazon (AWS) und Google. Apple spielt noch keine Rolle und obwohl sie viele Daten sammeln haben sie doch noch einen guten Ruf als Firma, die sichere und datenschutzfreundliche Betriebssysteme und Anwendung anbietet.

Wenn ich Vorträge zur KI halte, dann sind viele Teilnehmer überrascht, wenn ich sage, man kann sich sein LLM (Large Language Models, wie ChatGPT, Claude, Llama, …) auch lokal installieren und nutzen. Oftmals kommt dann die Frage: Aber KI braucht so unfassbar viel Rechenleistung und Strom. Das stimmt, für das Training! Für die Inferenz, also die Abfrage, nicht. Je nach Rechner, können Sie gute und/oder grosse Modelle auf Ihrem Rechner zu Hause installieren. Oder Sie nutzen LLMs, die zwar im Internet, aber datenschutzfreundlich, sind.

Optionen

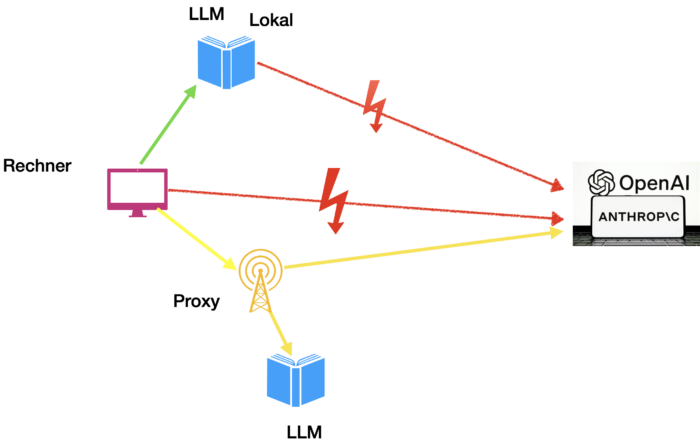

Sie haben mehrere Möglichkeiten, GenAI datenschutzfreundlich zu nutzen. Wie immer gilt: Es hängt an Ihnen, Ihrer Hardware, Ihrem Willen, welche Sie für sich nutzen wollen. Folgendes Bild veranschaulicht, welche Optionen es gibt.

Die roten Pfeile und Blitze signalisieren, dass hier Ihre Daten ungehindert an die Anbieter abfliessen und von mir daher nicht empfohlen sind. Ich komme gleich noch dazu.

Gelb ist schon besser, sie kommunizieren mit einem, meist Open Source, System und wenn es nötig wird oder Sie es wünschen, greifen diese Anbieter auf die kommerziellen Systeme zu. Dabei werden Ihre Daten über Proxies umgeleitet, so dass die Anbieter der generativen KI aus Infrastruktursicht keine Rückschlüsse auf Sie herleiten können. Aber die Inhalte der Prompts werden 1:1 weitergegeben, daher sollten Sie hier vorsichtig sein.

Der grüne Pfeil deutet an, dass hier keine Daten abfliessen, da alles auf Ihren lokalen Rechner bleibt. Diese Tools bieten Schnittstellen zu den kommerziellen Anbietern an. D.h., wenn das lokale Modell schwächelt und Sie ein kommerzielles Modell benötigen, bieten diese Tools eine Möglichkeit an. Die kommerziellen Anbieter ermöglichen den Zugriff via sog. API Keys, die meist zahlungspflichtig sind. So können die Fähigkeiten der Modelle in Applikationen eingebaut werden. Hier bedeutet es: Sie können mit Open Source Modellen lokal arbeiten, haben darüber hinaus aber zusätzlich die Möglichkeit, mit demselben Tool auch auf die großen Modelle der kommerziellen Anbieter zuzugreifen.

Chatbots ohne Konto verwenden

Die meisten Anbieter von KI wollen, dass Sie ein Konto anlegen, wenn auch kostenlos. Dazu habe ich in den vorangegenen Artikeln schon etwas gesagt. Es gibt auch andere Möglichkeiten.

Zum Beispiel ermöglicht lmarena.ai, dass Sie alle möglichen Modelle, Open Source und kommerziell, ohne Konto nutzen können. Sie können sogar, und das ist der Sinn dieser Seite, Modelle „gegeneinander antreten lassen“ und dann sagen, welches Ihrer Meinung die bessere Antwort gegeben hat. Diese Informationen gehen in eine Tabelle ein, welches Modell das Beste ist. Das erste Mal seit dieser Woche steht nicht mehr openAI mit ChatGPT an erster Stelle, sondern Gemini von Google.

Es kann passieren, dass bei kommerziellen Modellen, wie ChatGPT, Limits erreicht werden und diese LLMs dann nicht mehr antworten. Ich finde das aber nicht schlimm, dann nehme ich ein anderes Modell.

Ein eher datenschutzfreundlicher Anbieter eines LLMs ist venice.ai. venice.ai sammelt und verkauft keine Nutzerdaten. Anfragen laufen über einen Proxy und diese sind alle verschlüsselt. Venice speichert sehr wenige Daten, die nötig sind, um den Dienst anzubieten. Sie verwenden ausschließlich Open Source Modelle, die in mehreren unterschiedlichen Datenzentren gehostet werden. Es ist kein Konto notwendig oder sie können eine dummy E-Mail verwenden. Wenn Ihnen der Dienst gefällt, können Sie einen Premium Dienst buchen und wenn Sie wollen, mit Kryptowährungen bezahlen.

Denken Sie daran, venice.ai ist nur ein Frontend zu den Systemen, also werden alle Ihre Prompteingaben durchgereicht. Wenn Sie bei Open Source Modellen und unbekannten Rechenzentren Bauchschmerzen haben, dann halten Sie sich mit privaten Informationen zurück. Das Logging ist ebenfalls verteilt und dezentralisiert und daher wäre es sehr aufwändig, Rückschlüsse auf bestimme Nutzer zu ziehen. Die Anbieter der Modelle (openeAI, Anthropic, …) können so nicht erkennen, welches Prompt von wem kommt, auch über längere Sitzungen. Ein Schaubild von venice.ai zeigt vereinfacht, wie sie das erreichen.

Ihre Eingaben im Prompt landen bei venice.ai, die diese dann weiterleiten. Die Antwort kommt wiederum über den Proxy zurück. Bei vielen Anfragen ist es für die Anbieter der Modelle so schwierig, die Anfragen den jeweiligen Personen zuzuordnen, wenn sie das überhaupt wollen.

Das Problem mit Proxys ist immer, dass diese alle Informationen haben, wie bei VPNs auch. Daher ist es wichtig, sich dessen bewusst zu sein. Wenn Sie Ihrem VPN Anbieter vertrauen, nutzen Sie diesen. So müssen Sie sonst venice.ai vertrauen. Da aber auch andere venice.ai empfehlen, zum Beispiel Naomi Brockwell, habe ich ein gutes Gefühl, zumindest besser als bei anderen.

Brave Leo

Wenn Sie den Brave Browser verwenden, der von vielen Sicherheits- und Datenschutzexperten empfohlen wird, können Sie Leo von Brave verwenden. Brave Leo loggt nichts mit und erstellt auch kein Profil. Wenn Sie die Seite im Browser verlassen, in der Sie Leo verwendet haben, wird auch in Leo alles gelöscht. Sie können in den Einstellungen verschiedene LLMs auswählen, standardmässig nutzt Brave Mistral aus Frankreich. Außerdem bietet Brave ein „Bring your own model“, sie können also auch eigene Modelle einbinden. Brave hosted die Modelle bei sich, das heißt sie sind nicht bei den Anbietern. Um die Daten zu schützen, verwendet Brave Leo zum Zugriff auf die LLMs einen sog. Reverse Proxy. Das ist sicherer und datenschutzfreundlicher. Wenn Sie Brave Leo zu intensiv nutzen, verlangt die Firma $14,99 pro Monat. Um sich ein paar Seiten zusammenfassen zu lassen reicht es allemal.

Lokale Chatbots und LLMs

Wenn Sie ganz sicher sein wollen, das keine Daten über Sie gesammelt werden, können Sie LLMs bei sich lokal auf Ihrem Rechner installieren. Das sind immer Open Source Modelle. Davon gibt es sehr sehr sehr viele. Doch wie machen Sie das und welche Modelle sind Stand November 2024 gut lokal zu nutzen?

Vorteile lokaler LLMs

Sie haben keine Kosten. Es sind alles Open Source Modelle, die Sie auf Ihrem Rechner einfach so benutzen dürfen. Ausserdem geben Sie keine Daten an BigTech Firmen, die Sie damit überwachen, Profile erstellen, verkaufen und monetarisieren können. Sie benötigen keine Internetverbindung. Wenn Sie im Flugzeug oder der Bahn sitzen, kann das wirklich hilfreich sein. Daher empfehle ich Ihnen, auch wenn Sie ein Konto bei einem kommerziellen Anbieter haben, ein gutes Modell lokal bei sich zu installieren. Sie können beliebig viele LLMs lokal nutzen, was die Festplatte hergibt. Wenn Sie ein Tool (siehe unten) verwenden, können Sie Ihr Konto bei OpenAI, Anthropic etc. einbinden (siehe oben API Key). Sie nutzen das lokale LLM kostenlos und wenn Sie damit nicht zufrieden sind, wechseln Sie auf das externe kommerzielle Modell. So sparen Sie immer noch Daten. Wenn Sie Retrieval Augmented Generation benutzen, also von dem LLM private Dokumente verarbeiten lassen wollen, dann bleiben diese lokal, bei Ihnen. Sie werden nicht ins Internet gesendet, ausgewertet und zum Lernen und zur Profilerstellung verwendet.

Nachteile lokaler LLMs

Sie können lokal nur Open Source Modelle installieren. Kommerzielle Modelle wie ChatGPT oder Claude sind nicht möglich. Der Speicher Ihrer Grafikkarte und des Rechners sind beschränkende Faktoren. LLMs sind besser, wenn Sie mehr Parameter haben (grob). Mehr Parameter heißt mehr Speicherbedarf. Wenn Sie 8 GB Speicher haben und ein Modell mit 40 GB laufen lassen wollen, wird das keinen Spaß machen oder einfach gar nicht funktionieren. Weiter unter sage ich ein bisschen mehr dazu. Wenn Sie im Zug an einem Notebook sitzen, kann der Akku schneller entladen. Grosse, komplizierte Anfragen oder welche mit vielen Dokumenten, die Sie nutzen wollen, könnten schlechtere Ergebnisse zeitigen. Aber ganz ehrlich: Laden Sie 100 Dokumente als Privatperson zu openAI? Wohl eher nicht und wenn Sie das tun, überlegen Sie es sich gut. Viele Menschen sind überfordert von der Modellvielfalt und wissen nicht, welches das Beste für sie ist.

Weiter unter stelle ich eine Liste auf, mit denen ich gespielt habe. Diese kann jeden Tag veraltet sein, weil neuere Versionen besser sind. Aber grundsätzlich können Sie sich an diesen orientieren.

Hinweis: Mistral, ein von mir favorisierter Anbieter, hat sein Geschäftsmodell geändert und ist von Open Source weggegangen. Daher werden Sie die neuen Modelle nicht mehr lokal nutzen können.

Applikationen zur Nutzung lokaler LLMs

Zuerst können Sie sich Applikationen installieren, die Ihnen einen grossen Teil der Arbeit abnehmen. Es gibt davon auch immer mehr. Ich habe Msty und LMStudio getestet und bin mit beiden zufrieden. Andere sind GPT4All oder FreedomGPT. Ich denke, der Einstieg bei Msty ist niedriger und es ist für Menschen ohne Vorkenntnisse einfacher, zumal ein gutes Modell, Gemma2b, automatisch mit installiert wird. LMStudio scheint etwas „mächtiger“ zu sein, aber damit zu Anfang auch schwieriger.

Bei Msty können Sie bis zu drei LLMs gegeneinander antreten lassen, LMStudio erlaubt es Ihnen, einen Webserver einzurichten, so dass Sie von überall in Ihrem Netz darauf zugreifen können. Gerade wenn Kinder im Hause sind, können Sie so helfen und die Kontrolle behalten. Msty hat eine kuratierte Liste mit Modellen, aus denen Sie auswählen können. Das ist für Einsteiger hilfreich. Die Modellgrösse und der benötigte Speicher stehen dabei. Sie können trotzdem andere Modelle integrieren, sind also nicht eingeschränkt.

Wenn Sie auf Ihrem Windows oder Mac schon einmal das Terminal (cmd, terminal) verwendet haben, könnte Ihnen auch ein Llamafile dienlich sein. Llamafiles sind LLMs, die sie lokal auf Ihrem Rechner ausführen können, ohne jedwedes anderes Tool.

Es wird ein Webserver installiert, dann können Sie wie gewohnt mit Ihrem Browser auf den Chatbot zugreifen. Sie laden sich ein passendes Llamafile herunter, gehen ins Terminal und starten es einfach, bspw. mit <name>.llamafile.

Auf HuggingFace, der Plattform für alle Open Source Modelle, finden Sie einige Modelle. Für mich war ein gutes Beispiel: llava-v1.5-7b-q4.llamafile.

Ausprobierte Modelle

Hinweis: Die Modelle in Msty und LMStudio können Sie auch jeweils in dem anderen Tool verwenden. So habe ich es auf einem Mac mit 18 GB Hauptspeicher verwendet, aber probieren Sie aus, lernen Sie, spielen Sie, es ist wirklich toll.

Llamafiles

Hermes-3-Llama-3.1-8B.Q4_K_M.llamafile

llava-v1.5-7b-q4.llamafile

gemma-2-9b-it.Q4_K_M.llamafile

Msty

Gemma2b (eingebaut)

Alle, die Msty vorschlägt

(achten Sie auf den Hauptspeicherbedarf)

LMStudio

Dolphin-Modelle von Mistral

Dolphin 2.8 Mistral 7B v02

Dolphin 2.9.1 Yi 9B

Meta Llama 3.1 8B Instruct

Jetzt haben Sie Ihre eigenen Modelle am Laufen, sparen Daten und können vieles ausprobieren.

Im nächsten Teil schauen wir uns an, wie LLMs angegriffen werden können und Angreifer sie so dazu bringen können, Antworten zu geben, die sie gar nicht geben wollen oder sollen.